Запрет на индексирование внешних ссылок сайта

И так всем известно, что есть код noindex, но он закрывает к индексированию только для Яндекса, Google его не воспринимает, что же тогда делать спросите Вы? Всё очень просто дорогие мои. У сайтов в системе uCoz есть такая прекрасная функция как автоматическая замена внешних ссылок при помощи сервиса u.to.

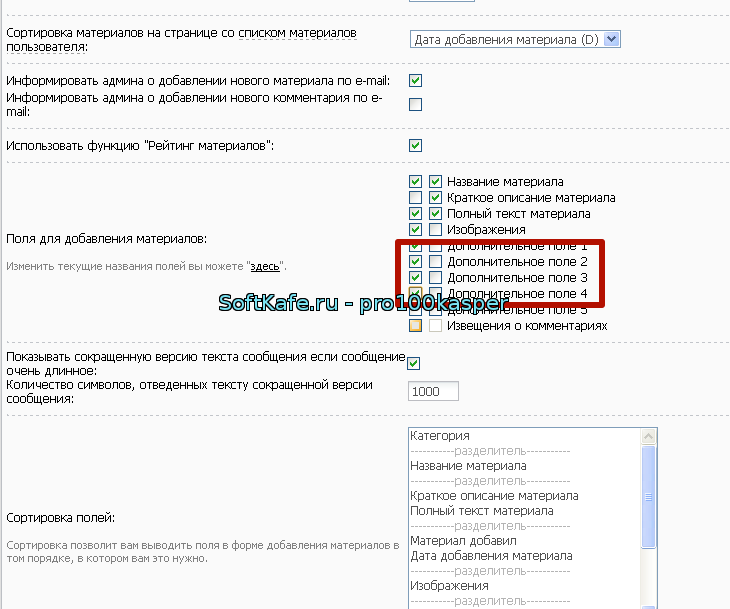

Суть этого сервиса состоит в том, что он укорачивает ссылки сайта, а так же даёт возможность следить за статистикой ссылок, а именно переходами и так далее. Наверняка все замечали, что на странице добавления и редактирования материала последним пунктом перед кнопкой добавить есть поле - Заменить внешние ссылки используя сервис u.to, так вот именно благодаря этому сервису мы и будем запрещать к индексации ссылки ведущие на чужой сайт. Что бы это сделать нам потребуется при каждом добавлении материала ставить галочку в этом поле,а в Robots.txt прописать директиву на запрет индексирования этих ссылок, а именно прописываем вот так: Disallow: *?.

Давайте разберем, что нам это дает:

1) Мы получаем статистику о переходах по ссылкам которые были сокращены через этот сервис.

2) Мы укорачиваем ссылки, а ведь всем известно, что поисковые системы не очень любят длинные ссылки.

3) Мы можем прописать директиву которая будет закрывать ссылки на чужие сайты к индексации.

Не плохо не правда ли? Данная функция существует во всех модулях uCoz сайтов, но вот на форуме её нет, что же делать спросите Вы? Я вам отвечу - ничего, так как она на форуме автоматически заменяет ссылки на ссылки от сервиса u.to, поэтому так же вписыванием директивы в Robots.txt мы так же и на форуме закрываем к индексации поисковыми системами все чужие ссылки.

Хотелось бы сразу ответить и на самый часто задаваемый вопрос:

Как автоматически заменить внешние ссылки сервисом u.to на всех ранее добавленных материалах?

Ответ:

Никак, Вам придется заново редактировать каждый материал сайта, который был добавлен ранее и где не была проставлена галочка в выше описанной функции.

Так же могу посоветовать Вам для упрощения и ускорения сканирования вашего сайта поисковыми системами добавить в Robots.txt запрет на индексирование таблицы стилей сайта, а именно добавить директиву: Disallow: /css.

Ну вот в принципе и все выложу в качестве образца содержание Robots.txt моего сайта:

Код

User-agent: *

Disallow: /a/

Disallow: /stat/

Disallow: /index/1

Disallow: /index/2

Disallow: /index/3

Disallow: /index/5

Disallow: /index/7

Disallow: /index/8

Disallow: /index/9

Disallow: /panel/

Disallow: /admin/

Disallow: /secure/

Disallow: /informer/

Disallow: /mchat

Disallow: /search

Disallow: /shop/order/

Disallow: /?ssid=

Disallow: *?

Disallow: /css

Host: clipak.ucoz.ru/

Sitemap: http://clipak.ucoz.ru/sitemap.xml

Sitemap: http://clipak.ucoz.ru/sitemap-forum.xml

Для тех кто не знает как получить доступ к редактированию файла Роботс.тхт - Вам потребуется создать на своём ПК обычный блокнот формата txt в него вписать все директивы, а после сохранить под именем robots.txt и загрузить в корень сайта ( в файловый менеджер ) после чего системный файл заменится созданным и загруженным на сервер вашим файлом. Ну вот и всё дорогие друзья. Если появляются вопросы не стесняемся пишем в комментарии отвечу на все.

13.01.2025

| Всего комментариев: 0 | |